При перепечатке материалов просим публиковать ссылку на портал Finversia.ru с указанием гиперссылки.

Насколько она хороша?

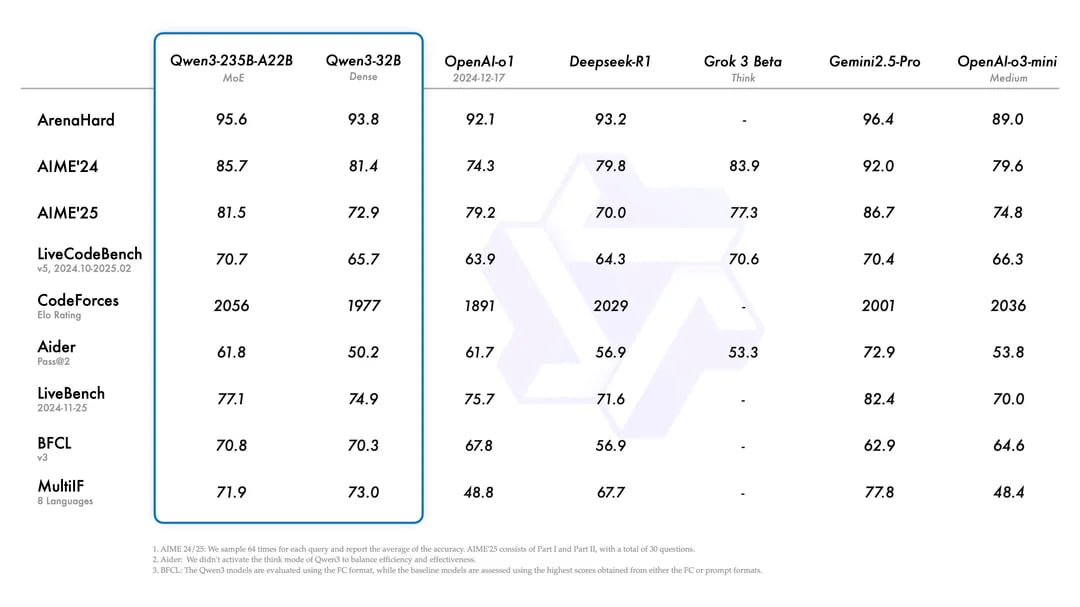

Вчера Alibaba представила семейство моделей Qwen3, которое по синтетическим бенчмаркам вырываются в группу лидеров, но … не является лидером по совокупности параметров, хотя заявка очень сильная.

Интегрально, Qwen3 конкурирует с Gemini 2.5 flash по соотношению цена/качество/производительность, опережая GPT o3 и o4-mini за счет лучшей доступности, но проигрывая по результативности, если цель состоит в генерации лучшего ответа/решения.

Моделей много, но выделю флагманскую - Qwen3-235B-A22B, которая активирует 22 млрд активных параметров из 235 млрд потенциально доступных, снижая требования к вычислительным ресурсам на 85%, сохраняя качество выходных токенов.

Qwen3 построены на базе архитектуры Mixture-of-Experts (MoE). Что это за зверь? Это подход в машинном обучении, который разделяет модель на специализированные подсети («эксперты»), активируемые динамически для каждого входного запроса. Её ключевая идея - повысить эффективность и качество модели за счёт условных вычислений, когда только часть параметров задействуется для обработки конкретного входа, позволяя генерировать токены быстрее и дешевле без потери качества.

Для понимания эффективности архитектуры, Qwen3-4B (4 млрд параметров!) превосходит Qwen2.5-72B-Instruct в задачах общего понимания, а MoE-версия Qwen3-30B-A3B обходит QwQ-32B, активируя лишь 10% параметров.

Для пользователей это означает возможность развертывания локальных очень мощных и производительных моделей с ограниченными ресурсами, буквально на домашних компах.

- Эффективность ресурсов: 235B-A22B требует на 65-70% меньше VRAM, чем Llama4 Maverick 402B.

- Скорость вывода: 320 токенов/сек на RTX 4090 против 180 у DeepSeek-R1.

- Точность длинного контекста: 98% на 32k контекстном окне против 75-95% у последних моделей конкурентов. Этот параметр показывает точность удержания контекстного окна, тогда как старые LLM «сыпались» при большом окне, забывая нить повествования и детали.

- Qwen3 изначально создавалась, как думающая модель (Thinking Mode), тогда как к Qwen2.5 этот модуль прикрутили через «костыли».

- Объём тренировочных данных увеличен в 3 раза - до 36 триллионов токенов, с акцентом на STEM-дисциплины (35% данных) и синтетические наборы для рассуждений.

• +42% точности в математических бенчмарках (MATH, AIME25)

• +37% эффективности в задачах программирования (LiveCodeBench)

• Поддержку 119 языков против 32 в Qwen2.5.

В сравнении с предыдущей версией и основными конкурентами Qwen3 демонстрирует прорыв в эффективности ресурсопотребления при сохранении лидирующих позиций в математических и кодирующих задачах.

Значительно улучшены возможности в мультимодальности (обработка видео и изображений), заявлена способность поглощать видео длительностью до 1 часа с точностью до секунды, не теряя детали.

По бенчмаркам выглядит достойно, но не идеально – в группе лучших LLM, но нужно смотреть детали.

Предварительный срез позволяет судить, что сейчас Qwen3-235B-A22B на третьем месте, уступая лучшей LLM в мире – GPT o3 и рядом с ней находящиеся Gemini 2.5 Pro, но выигрывая у Grok 3, и точно впереди DeepSeek R1, которые навел фурора в январе-феврале.

Весьма достойный ответ от китайцев, ждем DeepSeek R2, который должен выйти 15-25 мая. В начале мая Илон Маск обещал представить Grok 3.5. Конкуренция обостряется.

Qwen3 уже доступен бесплатно на официальном сайте.

Telegram канал автора: https://t.me/s/spydell_finance/

обсуждение